各 $i \in T$に対して

局所コンパクト空間 $\Omega_i$を次のように定める.

通常の統計学では,これは

「説明変数」

と呼ばれるものである.

ここで,

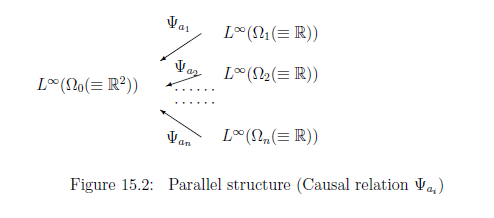

各$a_i$に対して,

決定的因果写像

$\psi_{a_i}: \Omega_0(={\mathbb R}^2)

\to

\Omega_{i} (={\mathbb R})$

を次のように定める.

これは,

次の決定的マルコフ 作用素

$\Psi_{a_i}:

L^\infty(\Omega_{i}) \to L^\infty(\Omega_0)$

と同値である.

したがって,同一視:$a_i \Leftrightarrow \Psi_{a_i}$のもとで,

「説明変数」は

因果関係 $\Psi_{a_i}$

を表すと解する.

各

$i=1,2, \cdots, n$, $L^\infty (\Omega_{i}(\equiv

{\mathbb R}))$内の

正規観測量

${\mathsf O}_{i} {{\equiv}} ({\mathbb R}, {\cal B}_{{\mathbb R}}, G_{\sigma_{}})$

を次のように定める.

したがって,

観測量

${\mathsf O}_{0}^{a_i} {{\equiv}} ({\mathbb R}, {\cal B}_{{\mathbb R}}, \Psi_{a_i}G_{\sigma_{}})$

(in

$L^\infty (\Omega_{0}(\equiv

{\mathbb R}^2))$

)

を次のように定義する.

よって, これらの同時観測量

${\mathop{\mbox{ $\times$}}}_{i=1}^n{\mathsf O}_{0}^{a_i} {{\equiv}} ({\mathbb R}^n, {\cal B}_{{\mathbb R}^n}, {\mathop{\mbox{ $\times$}}}_{i=1}^n \Psi_{a_i}G_{\sigma_{}})$

(in

$L^\infty (\Omega_{0}(\equiv

{\mathbb R}^2))$)

を次のように得る.

さて,ここで,正数$\sigma$を変数と見なして,$L^\infty ( \Omega_0 \times {\mathbb R}_+ )$内の観測量

${\mathsf O}=

\Big({\mathbb R}^n(=X) , {\mathcal B}_{{\mathbb R}^n}(={\mathcal F}),

F \Big)$

を以下のように定める:

[回帰分析(量子言語による)]

\sl

測定

${\mathsf M}_{L^\infty (\Omega_{0} \times {\mathbb R}_+)}(

{\mathsf O} \equiv (X, {\cal F}, F)

, S_{[(\beta_0,\beta_1, \sigma)]}

{}

)$によって,

測定値

$x=\begin{bmatrix}

x_1

\\

x_2

\\

\vdots

\\

x_n

\end{bmatrix}

( \in X={\mathbb R}^n )$

が得られたとしよう(通常の統計学では、この測定値のことを

「目的変数」

という).

ここで,状態

$

(\beta_0, \beta_1, \sigma_{}^2

)$

は未知として,

これらの

$

(\beta_0, \beta_1, \sigma_{}^2

)$

を測定値$

x=(

x_1, x_2, \ldots, x_n )

(\in {\mathbb R}^{n})$から推定せよ.

解答

$\log$-尤度

$L(\beta_0, \beta_1, \sigma^2, x_1, x_2, \cdots, x_n)=\log p_{(\beta_0, \beta_1, \sigma )}

(x_1, x_2, \cdots, x_n )$

を

$\beta_0$,

$\beta_1 $,

$\sigma_{}^2$

に関して,偏微分して,

次を得る.

\begin{align}

&

\frac{\partial L}{\partial \beta_0}=0 \quad \Longrightarrow

\quad

{\sum_{i=1}^n

{(x_i - (\beta_0 + {{}} a_{i{}} \beta_1 ))}

}

=0

\tag{15.20}

\\

&

\frac{\partial L}{\partial \beta_1}=0 \quad

\Longrightarrow

\quad

{\sum_{i=1}^n

{a_{i{}}(x_i - (\beta_0 + {{}} a_{i{}} \beta_1 ))}

}

=0

\tag{15.21}

\\

&

\frac{\partial L}{\partial \sigma^2}=0 \quad

\Longrightarrow

-\frac{n}{2\sigma_{}^2}

+

\frac{1}{2\sigma_{}^4}

{\sum_{i=1}^n ({}x_i - \beta_0 - \beta_1 a_i{})^2 }

=0

\tag{15.22} \end{align}

注意15.4

さて,ここで,

集合$T=\{ 0,1,2, \cdots, i , \cdots, n \}$は

次の半順序構造を持つとしよう.

\begin{align*}

0 < i

\qquad(i=1,2, \cdots, n)

\end{align*}

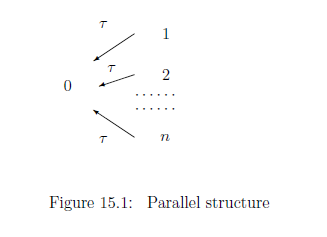

同じ意味で,木構造

$(T, \tau: T \setminus \{0\} \to T )$

において, 親写像$\tau: T \setminus \{0\} \to T$が次図を満たす:

$\fbox{注釈15.1}$

回帰分析においては、

"古典決定的因果作用素"に集中する.

したがって,

定理 12.8によって、

並行構造に限定しても一般性を失わない。,

したがって,

記法

(15.7)-(15.9)

から,

次を得る.

\begin{align}

&

\hat{\beta}_0(x)=\overline{x}

-\hat{\beta}_1(x) \overline{a}=\overline{x}

-\frac{s_{ax}}{s_{aa}} \overline{a},

\quad

\hat{\beta}_1(x)=\frac{s_{ax}}{s_{aa}}

\tag{15.23}

\end{align}

そして,

\begin{align}

&

(\hat{\sigma_{}}(x))^2=

\frac{\sum_{i=1}^n \Big( x_i - (

\hat{\beta}_0 (x)+ a_{i{}} \hat{\beta}_1 (x) )

\Big)^2}{n}

\nonumber

\\

=

&

\frac{\sum_{i=1}^n \Big( x_i - (

\overline{x}

-\frac{s_{ax}}{s_{aa}} \overline{a})

-

a_i

\frac{s_{ax}}{s_{aa}}

\Big)^2}{n}

=

\frac{\sum_{i=1}^n \Big(( x_i -

\overline{x})

+(

\overline{a}

-

a_i)

\frac{s_{ax}}{s_{aa}}

\Big)^2}{n}

\nonumber

\\

=

&

s_{xx}

-

2 s_{ax}\frac{s_{ax}}{s_{aa}}

+

s_{aa}(\frac{s_{ax}}{s_{aa}})^2

=

s_{xx} -

\frac{s_{ax}^2}{s_{aa}}

\tag{15.24}

\end{align}

であることに注目してもらいたい.

したがって,

小さな技法(最小二乗法)を大きな物語(量子言語)の中で,

理解できたと考える.簡単な最小二乗法を,量子言語の中で(または,統計学の中で)理解するためにわざわざ複雑にしたのが,回帰分析であるが,もちろん,それには意味がある.

$(A):$

「最小二乗法:(15.6)」と

「回帰分析

(15.23)と(15.24)」

は同じ結果

すなわち、計算結果は

回帰分析として理解すれば,量子言語(または,統計学)の中の他の理論(信頼区間法や仮説検定)と関連付けることが可能になるからで,このことを次節で述べる.

15.2: 最小二乗法と回帰分析(量子言語の中での意味づけ)

This web-site is the html version of "Linguistic Copehagen interpretation of quantum mechanics; Quantum language [Ver. 4]" (by Shiro Ishikawa; [home page] )

PDF download : KSTS/RR-18/002 (Research Report in Dept. Math, Keio Univ. 2018, 464 pages)

問題15.3 [回帰分析の量子言語表現]